La question du signal faible, ou « signe d’alerte précoce », est inhérente à la veille (qui se veut anticipative par nature) mais aussi par extension à

l’e-réputation : peut-on identifier à l’avance une possible crise ou une information critique ? Cette question est toujours ouverte à l’heure actuelle, et les réponses qui lui sont

données restent généralement techniques (l’outil magique). Petit retour sur cette problématique.

La question du signal faible, ou « signe d’alerte précoce », est inhérente à la veille (qui se veut anticipative par nature) mais aussi par extension à

l’e-réputation : peut-on identifier à l’avance une possible crise ou une information critique ? Cette question est toujours ouverte à l’heure actuelle, et les réponses qui lui sont

données restent généralement techniques (l’outil magique). Petit retour sur cette problématique.

Peut-on prévoir l’avenir ? Peut-on, à partir d’une opinion, d’une information, du traitement de certaines données, prévoir les comportements des internautes ? Peut-on dire que tel événement ou tel fait lié à une organisation aura un impact sur sa réputation en ligne ? Ou nécessitera une prise de décision anticipative ?

Avant toute chose il convient de revenir sur la notion même de signal faible, puis d’exposer non-pas des formules magiques, mais des réflexions méthodologiques sur l’identification et le traitement de signaux faibles. Car comme nous allons le voir, il s’agit plus de signes, donc d’une construction de la part de l’observateur, que d’une réalité tangible que chacun pourrait traiter de la même manière.

Notons que certaines réflexions sont issues d’un papier réalisé avec Christophe Deschamps et accessible sur HAL.

Le signal faible existe-t-il vraiment ?

Selon Igor Ansoff (dans son article fondateur de 1975) les décideurs sont confrontés à des « surprises stratégiques » (il ne parle pas encore de signaux faibles) dans leurs environnements concurrentiels. Ces « surprises » peuvent sensiblement modifier les prises de décision, voire faire perdre des marchés, du chiffre d’affaires, etc.

En 1984, Ansoff et McDonnell reviennent sur cette notion de surprise stratégique pour la définir en tant que signal faible, à savoir : « Un fait à propos duquel seules des informations partielles sont disponibles alors qu’une réaction doit être entamée, si l’on veut qu’elle soit parachevée avant impact sur la firme de l’évènement nouveau ».

Par la suite, en France, d’autres chercheurs se sont intéressés à la question, notamment Sylvie Blanco qui dans sa thèse de Doctorat parle de « signe d’alerte précoce » et définit certains des aspects suivants :

Ce qui mérite d’être souligné est que l’on ne parle plus de « signal » mais de « signe » : cela sous-entend alors que chaque signe ne sera pas interprété de la même manière en fonction des individus et du contexte dans lequel ils perçoivent ce signe.

Si certains signes informationnels paraissent avant-coureurs d’un événement, il parait illusoire de rechercher un signal qui sera compréhensible par tous. En bref, même si sur le web il est possible de traiter des grands jeux de données, même si la capacité de calcul et de crawling des outils s’améliore, identifier un événement pouvant et devant impliquer une prise de décision reste pour l’instant un acte purement humain… Pour l’instant ?...

Lorsque l’on parle d’e-réputation deux questions émergent : identifier une information ou une opinion qui ira à l’encontre ou qui appuiera les stratégies de l’organisation (en termes d’image, de communication, de marketing, etc.). Et définir les mécanismes propres à chaque plate-forme pouvant rendre visibles et accessibles cette information/opinion à des publics donnés. Mais là encore, seule une connaissance des dites plates-formes et la mise en place d’un processus d’identification efficace peut répondre à ces problématiques. Ainsi que l’intuition ?...

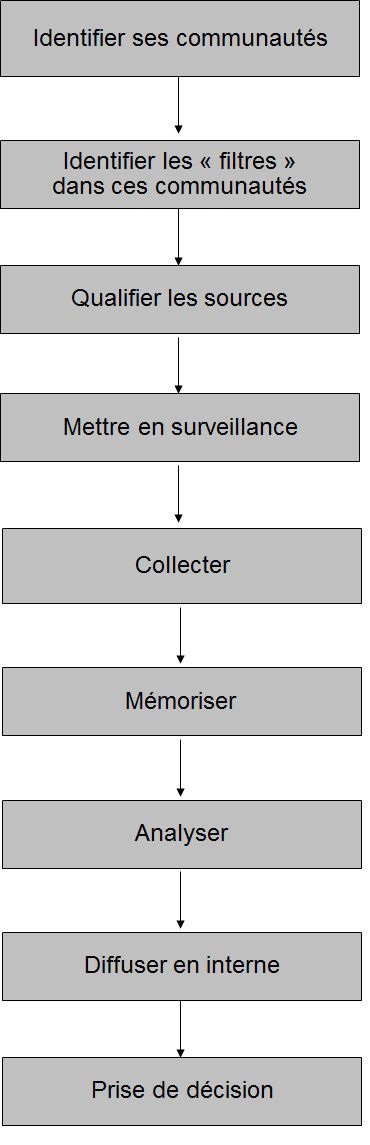

Identifier des signes d’alertes doit donc passer par une approche méthodologique et managériale clairement définit, et dont voici les contours.

Délimiter son territoire et son contexte de veille

Comme le rappel Sylvie Blanco, un signe d’alerte est « fragmentaire », il ne s’agit que d’une bribe d’information nécessitant d’obtenir des informations complémentaires pour constituer un potentiel signal.

Rien ne sert d’essayer de tout surveiller (même si cela semble possible avec le traitement des « big data »). Mais au contraire, il s’agit de délimiter précisément les communautés, plates-formes, acteurs et internautes qui ont réellement un intérêt stratégique pour l’organisation.

Si, par exemple, un sujet est fortement discuté sur une plate-forme où l’organisation ne souhaite pas aller, qui plus est par des publics n’ayant pas été identifiés comme prioritaires par l’organisation (ce ne sont pas des clients par exemple), alors qu’elle intérêt de surveiller en continu ce qu’il s’y dit ?

Définir son territoire de veille revient à se poser les bonnes questions pour évaluer son périmètre :

==> Quelles sont les communautés d’internautes ou les réseaux qui intéressent l’organisation ?

==> Où l’organisation souhaite-t-elle communiquer, et avec qui ?

==> Qu’est-ce qu’une « information critique » pour l’organisation ? Autrement dit, doit-on traiter comme signe d’alerte l’ensemble des informations fragmentaires diffusées sur une plate-forme ou dans une communauté, ou alors a-t-on déjà délimité ce sur quoi l’on doit porter son attention ?

Le territoire est donc là où l’organisation souhaite porter son regard (et sur quoi), délimitant ainsi clairement sa capacité à identifier un possible signe d’alerte (en allant chercher des informations complémentaires dans un contexte défini). Mais si l’on parle d’e-réputation, il convient aussi (voire surtout) de questionner le regard des internautes/publics :

==> Qu’est-ce qu’une information/opinion critique pour vos publics ?

==> Quelles sont généralement les informations les plus relayées (signaux forts) et celles sur lesquelles l’attention se prête moins en règle générale ?

==> Quels types de contenus sont largement (re)diffusés et quels autres le sont moins ?

==> Quelle typologie d’interactions autours de quels sujets (pour la mise en visibilité) ?

En bref, définir l’environnement informationnel dans lequel les publics de l’organisation et celle-ci évoluent afin de ne pas se focaliser sur chaque bribe d’information pouvant potentiellement représenter une opportunité ou ne menace…

S’appuyer sur les internautes et les collaborateurs pour le contexte

Largement traitée sur ce blog, la question de la prescription/recommandation d’information apparait comme l’un des points forts de la détection (ou plutôt de la construction donc) des signes d’alerte. En effet, au-delà des plates-formes comme Google qui par leurs mécanismes toujours flous permettent de rendre visibles très rapidement des informations habituellement peu accessible, identifier des prescripteurs, des filtres de l’information pour une communauté, apparait comme pertinent.

La question est alors : quelle information, encore peu relayée ailleurs, est recommandée par un filtres déjà identifié comme central pour une communauté, ou pertinent pour la veille de l’organisation ? Qui plus est quand ces « filtres » vont chercher des informations parfois peu ou pas indexées par les moteurs… Car ces filtres de l’information (sur Twitter par exemple) permettent non-seulement de faciliter l’accès à l’information, mais aussi de mettre en contexte celle-ci. Si le signal faible est une construction, alors la mise en contexte d’une même information effectuée par divers prescripteurs (avec un # sur Twitter, un commentaire sur Facebook, un lien sur un blog, etc.) permet de porter un regard différent sur cette information. Et ainsi identifier une information stratégique que l’on aurait pu laisser passer dans un autre contexte.

Avec Christophe, nous avons appliqué cette idée aux plates-formes dites de curation, et précisément Scoop.it et Pearltrees. Certains critères liés à l’identité numérique des « curateurs » sont alors tout autant de mise en contexte permettant d’identifier (i.e. de porter son regard sur) certaines informations ou certains contenus intéressant :

==> Les thématiques abordées, permettant ainsi de définir si le profil à surveiller est en adéquation avec les objectifs de veille ;

==> Le volume de contenus, donnant ainsi une idée du niveau d’exhaustivité sur un sujet du profil identifié (en comparaison par exemple avec une requête sur un outil) ;

==> Le nombre d’abonnés au compte, afin d’avoir une idée de la « qualité » du compte et de son intérêt pour une communauté donnée. Plus la communauté sera experte sur un domaine, plus le nombre d’abonnés démontrera la pertinence possible du compte ;

==> La description de l’utilisateur, à savoir la façon dont il se met en scène, ce qu’il souhaite mettre en avant de lui. Ainsi que potentiellement les autres comptes et sources où il diffuse ses découvertes ;

==> L’hétérogénéité des sources : utile pour élargir son propre sourcing de veille, cette information permet de définir si l’utilisateur a accès à des sources difficilement indexées ou non.

Bien entendu, cette approche s’applique à de nombreuses autres plates-formes. Ce que je vous montrerai plus tard avec certains résultats opérationnels de mes recherches (teasing :-)).

Enfin, si le signe d’alerte et une construction, il convient de s’appuyer sur les collaborateurs de l’organisation. D’une part car eux aussi ont accès au web et font surement une veille sur des sujets intéressant l’organisation. Et d’autre part car leur expertise sur certains sujets permet une meilleure mise en contexte, ou l’identification de bribes d’information pouvant amener à la sélection de signaux faibles. Il est alors nécessaire de prévoir dans son processus de veille l’intégration de cette veille souvent peu structurée des collaborateurs, voire des indicateurs ou une grille de sélection partagés afin de faire remonter au plus vite les informations jugées critiques ou en voie de le devenir.

Définir une indexation « en temps réel » efficace

Car si l’information circule en temps réel, si une veille ou un outil permet de la collecter voire de la traiter dans ce même temps, les prises de décisions ne se font jamais en directe. Pourtant, l’idée de signe d’alerte suppose (comme nous l’avons signalé) de prendre rapidement une décision à partir de peu de choses…

Il faut donc définir précisément sa stratégie de veille en « temps réel », et plus spécifiquement l’indexation des informations : quelles métadonnées utiliser pour transmettre une mise en contexte spécifique ? Quand indexer l’information ? Comment en faciliter l’accès ?

Les différentes étapes du processus de veille restent les mêmes, mais il semble intéressant d’intégrer l’indexation avant toute analyse en profondeur des informations collectées. Ainsi, avant toute remise en contexte due à l’analyse, chaque collaborateur pourra porter son regard sur l’information « brute » (ou mise en contexte par les internautes) et ainsi y déceler un possible signe nécessitant une action rapide de l’organisation.

S’appuyer sur certains outils

L’outil de veille qui vous permettra de collecter, traiter, mettre en contexte (pour vous et les publics), indexer et mettre en corrélation des bribes d’information n’existe pas (enfin à ma connaissance). Cependant, certains outils existant peuvent vous offrir un appui intéressant à l’analyse et la détection de signes d’alerte précoces. Le meilleur restant bien entendu votre cerveau et votre expertise/connaissance des thématiques, du web, des communautés et de l’organisation.

Notons rapidement :

==> Infomous. Cet outil va vous permettre de visualiser et de regrouper les contenus diffusés sur une plate-forme ou dans une communauté donnée. Si, par exemple, une information ou un contenu sont peu relayés, Infomous vous permettra de les visualiser rapidement (« bulle » plus petite) et donc de vous questionner à son propos ;

==> Gephi ou NodeXl. Ces outils de cartographie (qui plus est si vous investissez dans un accès aux API des plates-formes) vont vous permettre notamment d’identifier les liens faibles d’un réseau (et plus largement de définir des communautés). Vous pourrez ainsi identifier les acteurs à surveiller et définir par la suite les informations vous semblant en marge de ces communautés, ou au contraire celles étant sur le point d’être fortement relayées (en fonction des relayeurs donc) ;

==> TAGSExplorer. Plus orienté sur Twitter, cet outil mélange cartographie des liens et indexation des tweets. Facile d’accès (contrairement à Gephi par exemple qui demande de s’y pencher sérieusement), il vous permet d’identifier les tweets les plus populaires, les utilisateurs les plus centraux, etc.

Au final…

Il est plus facile d’identifier un signe d’alerte précoce, ou signal faible, après-coup qu’avant. Pour l’anticiper, il convient alors de le construire.

Mais cela n’est pas sans risque lorsque l’on traite d’e-réputation, et lorsque l’on a peur des « crises ». En effet, à vouloir gérer ce qui ne relève parfois que d’un épiphénomène, une organisation peut rapidement rendre visible un sujet ou créer l’évènement là où il n’y avait à la base aucune raison de s’affoler. Le tout est donc de bien préparer (au niveau technique et managérial) le traitement de ces bribes d’information souvent captées au détour d’une veille, et dont l’intuition nous pousse parfois à y prêter plus d’attention qu’il ne faudrait.

Et vous, que pensez-vous de la notion de signal faible ? Comment procédez-vous pour les identifier ?!